El Premio Nobel de Física 2024: imitando el comportamiento del cerebro humano

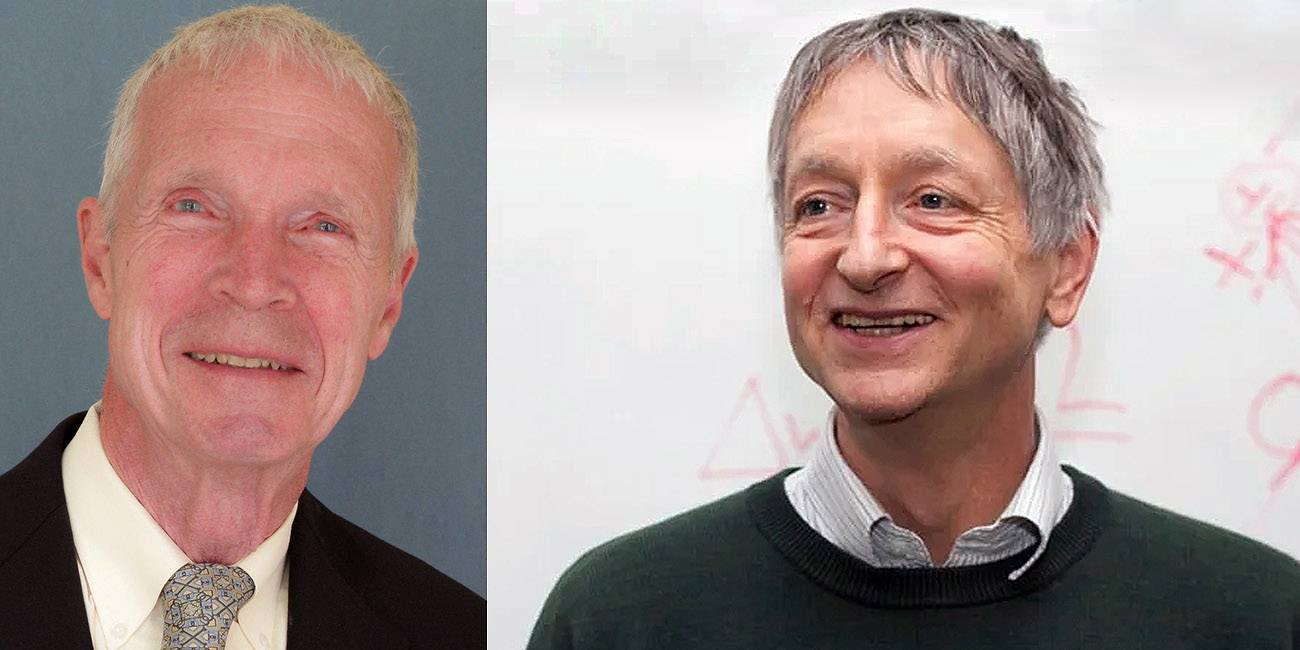

El pasado 8 de octubre, la Real Academia Sueca de Ciencias decidió otorgar el Premio Nobel de Física 2024 a John J. Hopfield (Universidad de Princeton, Estados Unidos de América) y a Geoffrey Hinton (Universidad de Toronto, Canada), por sus “descubrimientos e inventos fundamentales que permiten el aprendizaje automático con redes neuronales artificiales”.

El anuncio tomó por sorpresa a muchos, quienes apostaban por el reconocimiento a investigaciones desarrolladas en ramas del conocimiento más claramente identificables con lo que comúnmente se entiende por “física”. Las palabras emitidas por la Profesora Ellen Moons, Presidenta del Comité Nobel de Física, parecen adivinar la controversia que generaría el otorgamiento del premio. El texto siguiente es una traducción libre del discurso ofrecido por la Profa. Moons (el video correspondiente está accesible en [1]):

| “Aprender es una habilidad fascinante del cerebro humano. Podemos reconocer imágenes y discursos, además de asociarlos con recuerdos y experiencias pasadas. Miles de millones de neuronas conectadas entre sí nos brindan capacidades cognitivas únicas. Las redes neuronales artificiales se inspiran en esta red de neuronas de nuestro cerebro. Los laureados con el Premio Nobel de Física de este año, John Hopfield y Geoffrey Hinton, usaron conceptos fundamentales de física estadística para diseñar redes neuronales artificiales que funcionan como memorias asociativas y encuentran patrones en grandes conjuntos de datos. Estas redes neuronales artificiales se han usado para avanzar en la investigación en ramas de la física tan diversas como son la física de partículas, la ciencia de materiales o la astrofísica. También se han convertido en parte de nuestra vida cotidiana, por ejemplo, en el reconocimiento facial y en la traducción de idiomas. Los descubrimientos e inventos de los laureados representan los ladrillos del aprendizaje automático, el cual puede ayudar a los humanos para tomar decisiones más rápidas y confiables, por ejemplo, en el diagnóstico de condiciones médicas. Sin embargo, mientras el aprendizaje automático tiene enormes beneficios, su rápido desarrollo también ha suscitado inquietudes sobre nuestro futuro. Para el mayor beneficio de la humanidad, los humanos tenemos la responsabilidad colectiva de usar esta nueva tecnología en forma ética y segura” |

A continuación, revisamos algunos antecedentes que aspiran a facilitar la comprensión del impacto que ha tenido el trabajo científico de Hopfield y Hinton, tanto en el manejo como en el proceso de información. También argumentamos por qué, en opinión del autor, la decisión del Comité Nobel de Física no debería dar lugar a controversias.

El cerebro como objeto de estudio

Considerando que el cerebro es materia con un alto nivel de organización, no debería sorprender que su funcionamiento también sea del interés de la física, de forma complementaria a los objetivos de la biología y de la medicina (neurociencias). El pensamiento, aquello que asociamos indiscutiblemente –pero no exclusivamente– con nuestra especie, es la manifestación más clara de dicha organización.

La búsqueda del yo ha despertado el interés de pensadores e investigadores desde los albores de nuestra especie. Sin embargo, apenas no hace mucho, comprendimos que esa búsqueda debería dirigirse al cerebro. Aristóteles, por ejemplo, pensaba que el alma residía en el corazón y que el cerebro servía solo para refrigerar el sistema cardiovascular. Descartes, un poco menos errado, pensaba que la glándula pineal del cerebro era la clave para descubrir cómo es que el alma entra al cuerpo.

En todo caso, la mayor dificultad que ha enfrentado el estudio del cerebro humano radica en los aspectos éticos y morales que conlleva su práctica. Solo en tiempos recientes se permite examinar cadáveres humanos (como cabe esperar, los estudios correspondientes están regulados por normas y principios muy claros), pero esta actividad ha sido prohibida y castigada a lo largo de muchas épocas y en muchas culturas de nuestra historia. No obstante, como sistema dinámico, las características más interesantes del cerebro se presentan cuando tiene vida, por lo que las autopsias no revelan la forma en la que las diferentes partes del cerebro interactúan entre sí para generar pensamientos.

Hoy en día sabemos que el cerebro humano pesa aproximadamente kilo y medio, lo que supone el equivalente al 2 por ciento del peso corporal. Nuestra evolución está claramente registrada en la morfología del cerebro. Los estudios pioneros de Paul MacLean (1967), por ejemplo, permiten identificar tres porciones del cerebro con diferentes estadios evolutivos: (1) La parte más interna, identificada con las regiones posterior y central del cerebro, que contienen los ganglios basales, el cerebelo y el tronco encefálico, está asociada con los latidos del corazón, la respiración, la digestión y otras funciones básicas de supervivencia. Esta corresponde al estadio reptiliano. (2) La parte intermedia, identificada con el sistema límbico, que contiene el hipocampo, la amígdala, el tálamo y el hipotálamo, rodea una buena porción del cerebro reptiliano y está asociada con el comportamiento social. Esta es la porción del cerebro que nos hace mamíferos. (3) La parte más externa, la corteza cerebral, contiene lo más adelantado de la evolución, la neocorteza, y nos distingue como una especie de mamíferos muy singular. De acuerdo con Carl Sagan, la naturaleza no derrocha, sino que optimiza. Antes de desechar lo que es útil, lo mantiene y agrega nuevas estructuras, que conviven con las anteriores. El cerebro humano, en la interpretación de MacLean, ha seguido esta premisa durante su evolución.

La neocorteza está particularmente desarrollada en nuestra especie, constituye cerca del 80 por ciento de nuestro cerebro. La evolución incrementó esta región cerebral sin apenas aumentar las dimensiones de la bóveda craneana: la neocorteza es básicamente delgada y muy extensa, como una enorme sábana, que se corruga y se pliega en el interior del cráneo a fin de optimizar el espacio en el que se encuentra contenida. Esta es la porción del cerebro que nos hace humanos; regula emociones basadas en la percepción del mundo inmediato, además de estar asociada con la actividad cerebral más elaborada y sofisticada: el pensamiento.

En general, la neocorteza procesa la información que proviene de nuestros sentidos. De acuerdo con François Chaussier, esta zona del cerebro se divide en cuatro lóbulos, especializados en diferentes funciones. El lóbulo occipital, en la región donde la cabeza se une con las vértebras del cuello, el occipucio, procesa la información proporcionada por los ojos. El lóbulo parietal en la parte superior del cerebro, procesa información asociada con la representación de nuestro cuerpo. El lóbulo temporal, en la región de las sienes, regiones mediales-inferiores, procesa el reconocimiento visual de los rostros y, en su parte izquierda, el lenguaje. El lóbulo frontal, en la región de la frente, básicamente se encarga de procesar el pensamiento racional. Con esta región de la neocorteza se asocia la capacidad para hacer planes.

Morfológicamente, el cerebro consta de dos hemisferios o mitades, derecho e izquierdo. El entendimiento de que cada uno de estos hemisferios está especializado en tareas distintas y que no son, ni de lejos, uno la copia del otro, se debe a Roger W. Sperry —Premio Nobel de Fisiología o Medicina 1981—. Estos hemisferios se complementan entre sí, la información se procesa pasando de uno al otro. El lado izquierdo controla la parte derecha de nuestro cuerpo, es un tirano analítico y lógico que domina al lado derecho, más propenso a las actividades artísticas y controlador de la parte izquierda de nuestro cuerpo. Lo sorprendente es que el cerebro puede funcionar aún cuando uno de los hemisferios es extirpado. Sperry encontró que cada uno de estos hemisferios genera pensamientos propios, incluso contradictorios entre sí, que coexisten y procesan información en forma paralela con respecto a las señales que reciben de los sentidos. Al seccionar el cuerpo calloso, que conecta los dos hemisferios, la información deja de fluir de un lado al otro del cerebro, el hemisferio derecho queda liberado del yugo del hemisferio izquierdo y el paciente presenta la sintomatología del cerebro dividido (la mano izquierda, por ejemplo, al ser controlada por el hemisferio derecho, se comporta con independencia de los deseos del paciente, que son regulados por el hemisferio izquierdo). ¿Doctor Jekyll y Mister Hyde? Sin la mediación del cuerpo calloso, ¿cuál de los dos hemisferios concentra la información que define el yo?

Neurociencia y Física

Muchos historiadores ubican el origen de la neurociencia moderna en 1848, cuando una barra de hierro atraviesa el cerebro de Phineas P. Gage, capataz de 25 años que laboraba en la construcción de una línea férrea en Vermont, Estados Unidos de América. Gage sobrevivió al terrible accidente, no sin experimentar cambios drásticos en su personalidad que incluían dificultades para hacer y concretar planes. El caso fue documentado y reportado por John M. Harlow, médico tratante, a la comunidad científica de su área. A la muerte de Gage, acaecida en 1860, Harlow conservó el cráneo de su paciente. Estudios posteriores mostraron que el accidente afectó principalmente al lóbulo frontal del cerebro, lo que explicaba con puntualidad el cambio de personalidad observado en Gage. Poco después, en 1861, Paul Broca presenta evidencia contundente de la correspondencia entre una función cognitiva, el habla, y una zona específica de la corteza cerebral, actualmente conocida como zona de Broca. Se trata de un estudio anatómico post mortem realizado a pacientes con problemas de lenguaje oral.

El desarrollo de la neurociencia obedeció en sus orígenes a las desafortunadas circunstancias de pacientes como el Sr. Gage, sobrevivientes de accidentes que provocaban daño cerebral, en los que se podían analizar las consecuencias de afectar zonas concretas del cerebro, o del análisis post mortem efectuado en los cadáveres de pacientes con claras dificultades cognitivas, como el estudio reportado por Broca. Los avances, aunque importantes, se daban a cuentagotas debido a la imposibilidad de observar de forma dinámica, es decir, en vida, el comportamiento del cerebro.

La situación cambió gracias a los avances tecnológicos impulsados por investigaciones fundamentales en física. El cerebro es materia con un alto grado de organización. Si la morfología del cerebro se asocia con habilidades cognitivas —diferentes regiones cerebrales regulan diferentes funciones cognitivas—, entonces todas aquellas propiedades físicas asociadas con la materia de la que está hecho el cerebro deben corresponder de una forma u otra a las habilidades cognitivas. El ejemplo inmediato, y posiblemente el más claro, es la respuesta del cerebro a estímulos eléctricos.

Diversos estudios muestran que aplicando corrientes eléctricas apropiadas en regiones concretas del cerebro producen efectos concretos, desde activar movimiento en alguna parte del cuerpo hasta desenterrar recuerdos aparentemente olvidados. La conclusión natural es que el cerebro se comunica consigo mismo, y con el resto del cuerpo, fundamentalmente con impulsos eléctricos.

La buena noticia es que no requerimos abrir el cráneo para investigar el comportamiento del cerebro vivo, pues la física ofrece técnicas no invasivas para tal proeza. Lo que estaba vedado en el surgimiento de la neurociencia, porque se consideraba que estudiar un cerebro vivo estaba fuera del alcance de la ciencia en general, ha sido facilitado por una disciplina que explica el comportamiento del universo, incluyendo al ser humano como parte del mismo.

Una de las revoluciones en neurociencia viene tomada de la mano de la física, y se desarrolla a partir de mediados de los años noventa del siglo pasado. El advenimiento de una serie de fantásticos y sofisticados escáneres cerebrales, ha representado un impulso sustancial en el entendimiento del comportamiento del cerebro. La obtención de imágenes por resonancia magnética (MRI, por magnetic resonance imaging), es por mucho el logro más significativo de estas nuevas tecnologías. Con ellas se estudia el funcionamiento del cerebro mientras el paciente experimenta sensaciones corporales o emociones. El principio físico involucrado es sencillo: diversas señales electromagnéticas pueden atravesar tejidos orgánicos sin dañarlos. El aparato de MRI genera un campo magnético que interactúa con los núcleos de los átomos en el interior del cuerpo del paciente, en forma similar a la acción del campo magnético terrestre sobre una brújula: hay una propiedad de los núcleos, el spin, que se alinea con la dirección del campo.

Después se aplica una señal electromagnética adicional, esta vez ondas de radio, provocando que algunos de los núcleos se volteen en dirección antiparalela al campo magnético. Al regresar a su orientación anterior, los núcleos generan una señal electromagnética remanente que es captada por detectores especiales y enviada a una computadora para su análisis. La imagen del tejido estudiado es reconstruida con la información procesada por la computadora. El ciclo completo, aunque sencillo, requirió de años de investigación y de mucha inversión para materializarse como tecnología útil. Por ello, los costos tan elevados de esta clase de estudios de gabinete médico.

Otras tecnologías involucran la electroencefalografía (EEG), la tomografía por emisión de positrones (PET), el escáner electromagnético transcraneal (TES), la magnetoencefalografía (MEG) o la espectroscopía de infrarrojos cercanos (NIRS). Cada uno de ellos con ventajas o desventajas en su aplicabilidad. El camino no termina aquí. Un mejor entendimiento de la fisiología del cerebro, motivado por las tecnologías impulsadas por la investigación básica en física, permite implementar mejores tecnologías para su estudio, y estas últimas motivan nuevos modelos del comportamiento del cerebro. Y así sucesivamente.

Con la ayuda de la física hemos aprendido más del cerebro en los últimos treinta años que en el periodo comprendido desde Aristóteles hasta antes de 1990. Cabe mencionar que la física tardó siglos en desarrollar un modelo fehaciente del electromagnetismo que sustenta los dispositivos mencionados arriba, pero los resultados de esta aventura se reflejan con claridad en el soporte tecnológico con el que cuenta hoy en día el desarrollo de la neurociencia.

Neuronas, el ingrediente básico

La neocorteza está integrada por neuronas, las células cerebrales. Se estima que existen alrededor de cien mil millones de estas células en el cerebro humano. Cada una de ellas está compuesta por el soma (cuerpo celular), el cual contiene al núcleo y está rodeado por un sinfín de ramificaciones llamadas dendritas, y por una terminación alargada que recibe el nombre de axón. Este último se extiende por medio de unas ramificaciones alargadas que terminan en lo que se conoce como botones terminales. Las dendritas son los receptores de los impulsos nerviosos que son emitidos por otras neuronas. Estos impulsos son procesados por el núcleo para ser después transmitidos a través del axón y hasta los botones terminales, que liberan el impulso nervioso para ser detectado por otra neurona. Para comunicarse, las neuronas no tienen contacto entre ellas. Se aproximan entre sí hasta un espacio minúsculo conocido como sinapsis, donde se lleva a cabo la transmisión del impulso nervioso. En realidad, la sinapsis, o contacto, es una compuerta que regula el flujo de información ya sea por medio de compuestos químicos (neurotransmisores), o por medio de iones. Dependiendo de su especialización, las neuronas establecen contacto con vecinos a muy corto alcance, cientos de micrómetros, o a distancias mucho mayores como para conectar la espina dorsal con los músculos de los dedos de los pies, por ejemplo.

El cerebro procesa información de forma más eficiente, en tanto mayor sea el número de neuronas relacionadas entre sí. El proceso de aprendizaje se relaciona con el establecimiento de conexiones entre neuronas, igual que el proceso de memoria. Se entiende que una red neuronal robusta, donde hay un porcentaje mayor no sólo de neuronas conectadas entre sí, sino de regiones cerebrales conectadas entre sí, protege al cerebro de la pérdida de información y de funcionalidades cognitivas que representa la afectación fisiológica de alguna de sus partes.

El cerebro oculta información

¿Cómo es que el cerebro procesa toda la información que recibe de los sentidos? Por mucho que se trata de un órgano altamente sofisticado, compuesto por miles de millones de neuronas y una cantidad exponencialmente mayor de conexiones neuronales, el cerebro simplemente no procesa toda la información que recibe; optimiza. Pensemos en el ojo humano y en la capacidad de visión asociada con éste. La noción de profundidad a la que estamos acostumbrados en nuestra vida cotidiana, es resultado del intercambio de información entre los hemisferios derecho e izquierdo de nuestro cerebro, regulada como ya vimos por el cuerpo calloso, y no porque nuestro dispositivo ocular lo detecte. Es decir, “profundidad” no forma parte de la información enviada por nuestros ojos al cerebro, ya que la retina es una estructura bidimensional. Sin embargo, como estos distan entre sí por una cierta separación, los hemisferios combinan las dos imágenes y codifican la información como si hubiera sido colectada en tres dimensiones. Este fundamento es imitado en las películas anunciadas como de tercera dimensión. También explica la separación ocular característica de los mamíferos cazadores como los grandes felinos. Mirar al mundo en estéreo les da ventajas sobre su comida porque pueden atacar con mucha más precisión de la que la víctima en turno tiene a su disposición para escapar.

Otro aspecto característico del ojo humano fue descubierto por Rangar Granit, ganador junto con Haldan K. Hartline y Geroge Wald, del Premio Nobel de Fisiología o Medicina 1967. Resulta que hay varios tipos de conos, las células que regulan la visión a color, pero éstos son sensibles a luz de solo tres diferentes longitudes de onda: rojo, verde y azul. Esto significa que aún cuando colores como el amarillo o el naranja existen en la naturaleza, nuestra especie nunca los ha visto en realidad. Nuestro cerebro procesa la información visual combinando diferentes porciones de los únicos tres colores que son detectados por nuestros ojos.

También asociado con el ojo como dispositivo colector de información, nuestro campo de visión presenta un punto ciego justo donde el nervio óptico se encuentra con la retina. Además, solo la parte central de la retina, la fóvea, concentra la mayor cantidad de conos, por lo que se especializa en la visión en alta resolución. El resto de la retina está inundada de células fotosensibles monocromáticas, especializadas en detectar movimiento, llamadas bastones. Para colectar la mayor cantidad de información posible, el ojo se mueve constantemente, con sacudidas muy rápidas que son conocidas como movimientos sacádicos. Así, para compensar la información ausente por el punto ciego asociado con el nervio óptico, y para optimizar el uso de la pequeña región de la fóvea, el cerebro procesa toda esta información y calcula un promedio, reconstruyendo la imagen que deberíamos haber detectado con un dispositivo óptico cuya morfología no presentara las características de nuestros ojos.

La percepción de la realidad, al menos visualmente, es entonces una reconstrucción de nuestro cerebro al intentar compensar, y optimizar al mismo tiempo, los huecos e imperfecciones en nuestro campo de visión. El cerebro “oculta” este proceso proporcionando imágenes “continuas”, con alto grado de detalle, de aquello que es alcanzado por nuestra vista. ¿Es real lo que describimos por medio del sentido de la vista? ¿Qué es real?

Nuestro cerebro recibe mucha más información de la que puede procesar. ¿Cómo es entonces que tomamos decisiones ante, por ejemplo, una situación de peligro? Frente a emergencias u oportunidades el cerebro improvisa, toma atajos, supone cosas y corre riesgos para proporcionar una respuesta inmediata. Así como “completa” la información faltante en nuestro campo de visión, el cerebro descarta la mayor parte de la información que recibe tan pronto calcula que no la necesita. El cerebro también “oculta” este proceso resolviendo lo antes posible la encrucijada que se le presenta, y lo hace aplicando reglas generales, fáciles de aplicar, aunque no necesariamente sean lógicas. Por otro lado, para hacer operaciones matemáticas, donde no se requiere prontitud de respuesta, se decanta por los procesos metódicos, aunque resulten lentos.

La dificultad de las fotografías

Como se ha visto, la mayor parte del tiempo desconocemos lo que está haciendo nuestro cerebro. Las tareas más difíciles las lleva a cabo a escondidas. El complejo proceso con el que maneja la información que recibe para realizar incluso las tareas más sencillas, como identificar rostros, nos resulta oscuro de forma consciente. En un modelo simplista, motivado por la aparición de los aparatos electrónicos de cómputo, el cerebro se ha caricaturizado como una caja negra que opera por medio de algoritmos. Se le inyecta información y, después de algún tiempo, arroja información procesada usando dichos algoritmos. Caricaturizada porque son las computadoras las que se han diseñado a imitación del cerebro y no al revés. El modelo prosperó por un tiempo. Ya se ha mencionado que las nuevas tecnologías llevan a nuevos modelos del funcionamiento del cerebro y viceversa, pero pronto nos percatamos de que no es posible reproducir cualquier operación cerebral usando algoritmos y computadoras.

Para conseguir que una computadora imite mejor al cerebro humano le hace falta la “improvisación” y el aprendizaje que permiten la toma de decisiones.

Desde hace décadas se sabe que una computadora puede ganar al ajedrez jugando con un gran maestro. Pero esas mismas computadoras, en la época que iniciaron las pugnas ajedrecísticas con los humanos, eran incompetentes frente a un niño de tres años al momento de reconocer el rostro de “mamá” en una fotografía.

Hoy las cosas han cambiado sustancialmente. Hemos conseguido que las computadoras aprendan y que procesen información de forma aún más parecida a como lo hace el cerebro humano. Ya no es un reto que un dispositivo electrónico identifique rostros humanos, o huellas digitales, da igual. Por ello, entre otras cosas, estos dispositivos reciben el apelativo de inteligentes. ¿Dónde están los límites? No lo sabemos. ¿Habrá, algún día, una rebelión de las máquinas como augura la famosísima y genial película Terminator? Algunos pensamos que no, pero no está de más considerar las palabras de la Profa. Moons en el anuncio del otorgamiento del Nobel de Física de este año.

Inteligencia Artificial

Por Inteligencia Artificial se entiende la capacidad de un dispositivo electrónico para resolver problemas que requieren inteligencia. Es decir, problemas que no pueden resolverse con algoritmos y una computadora. Su origen puede trazarse a mediados de los años treinta del siglo pasado, con la propuesta de Alan Turing referente a la posibilidad de que exista un dispositivo capaz de imitar el comportamiento del cerebro humano, al grado de que sea imposible interactuar con él y distinguir que se trata de una máquina. Con su propuesta, Turing abrió la posibilidad de automatizar operaciones que, por necesidad, se consideran inteligentes.

Una de las ramas de la inteligencia artificial es el aprendizaje automático (machine learning), donde se busca resolver problemas con dispositivos electrónicos sin programar explícitamente el algoritmo de solución. La estructura fundamental de esta disciplina se inspira en los mecanismos de aprendizaje humanos, por lo que su desarrollo ha requerido la construcción de redes neuronales artificiales.

A imitación del caso biológico, una neurona artificial tiene un conjunto de entradas. Cada una de ellas representa información concreta y tiene asignado un peso determinado. El impulso nervioso recibido corresponde a la suma de los productos de las entradas multiplicadas con sus respectivos pesos. Este se procesa en el nodo mediante una función de activación y arroja un valor que es enviado a la salida. Como en el caso biológico, una red neuronal artificial se conforma de una cantidad suficientemente grande de neuronas artificiales, donde “suficientemente” se determina por el tipo de problema a resolver. A mayor cantidad de neuronas artificiales involucradas, mejor será el desempeño de la red correspondiente. Estas redes están compuestas por capas; en el caso general incluyen siempre una capa de entrada y una de salida. Las capas intermedias suelen llamarse ocultas. El concepto de aprendizaje profundo (deep learning) surge de considerar números muy grandes de capas ocultas.

El número de nodos de la capa de entrada coincide con el número de datos, input, que se introduce. Su función es pasiva, pues solo distribuyen la información de entrada a la siguiente capa. Los nodos de la segunda capa son activos, combinan la información que reciben de la capa anterior y proceden como está indicado en el párrafo anterior. El proceso se repite hasta llegar a la última capa, donde los datos se combinan y se modifican para producir los valores de salida. Las redes neuronales se usan en simulaciones y predicción de sucesos, reconocimiento, clasificación, modelización y procesamiento de datos.

Los ganadores del Premio Nobel de Física 2024

John J. Hopfield nació en 1933, Chicago, Illinois, Estados Unidos de América. Obtuvo su doctorado en 1958, en la Universidad de Cornell. En 1982 publica un artículo que cambiaría los paradigmas de la imitación del cerebro usando sistemas computacionales. El artículo se titula “Redes neuronales y sistemas físicos con habilidades computacionales colectivas emergentes” [2].

La red de Hopfield se basa en la acumulación de patrones y está estructurada de forma que, cuando se le introduce un patrón incompleto o dañado, es capaz de seleccionar de entre los patrones almacenados aquél que sea más similar. A este proceso se le llamó memoria asociativa. En su trabajo original, Hopfield utilizó una red con 30 nodos, lo que resulta en 435 conexiones, cada una de ellas con una intensidad particular, por lo que hay alrededor de 500 parámetros a considerar. Una tarea un tanto descabellada si se toma en cuenta el tipo de equipo de cómputo que existía en 1982.

Geoffrey E. Hinton nació en 1947, Londres, Reino Unido. Obtuvo su doctorado en 1978, en la Universidad de Edimburgo, Reino Unido. En 1985 publica un artículo titulado “La máquina de Boltzman” [3], donde reporta una versión estocástica del modelo de Hopfield. La red se basa en modelos estadísticos y está regulada por la distribución de Boltzmann, por lo que, a diferencia del modelo de Hopfield, se enfoca en distribuciones estadísticas de patrones antes que en patrones individuales. Esta máquina puede aprender, no a partir de instrucciones, sino de ejemplos. Cuando se le introducen patrones de ejemplo, estos tienen la mayor probabilidad de ocurrir. Esta red puede reconocer rasgos familiares en información que no ha visto previamente, igual que un niño puede reconocer un chicozapote –que no conoce– en una cesta donde hay plátanos y manzanas que le son familiares.

¿Por qué la controversia?

Los avances en el proceso de información impulsados por los resultados de Hopfield y Hinton son, sin lugar a duda, impresionantes. La transición de operar con base en algoritmos, a hacerlo basándose en aprendizaje, hace que los sistemas de cómputo sean, en efecto, dispositivos inteligentes. No debemos olvidar que la estructura de las computadoras con las que se desarrolla la inteligencia artificial se basa en las propiedades del silicio, y que éstas no son diferentes de aquellas que operan exclusivamente con algoritmos. Potenciar las capacidades de estos dispositivos sin cambiar su estructura básica es de por sí un hito en tecnología. Además, se ha conseguido un acercamiento importante a la automatización de operaciones que se consideran inteligentes, por lo que el ideal de Turing se antoja alcanzable.

Lo más importante, se trata de materia realizando operaciones que requieren un alto grado de organización, como el cerebro humano. El estudio continuado de estos procedimientos permitirá modelar aún mejor el comportamiento del cerebro, y ello repercutirá tarde o temprano en un entendimiento más profundo del pensamiento, por lo que estaremos en condiciones de generar más avances en la inteligencia artificial y así sucesivamente.

En medio de todo este proceso están los fenómenos físicos involucrados. ¿Por qué separar la relevancia de estos trabajos de la física cuando esta disciplina ha contribuido notoriamente en el desarrollo tanto de la neurociencia como de la informática? Hasta el momento, los modelos del funcionamiento del cerebro son no cuánticos. La tendencia en la tecnología del procesamiento de la información nos ha llevado a pensar en el cómputo cuántico que, a diferencia del cómputo convencional, opera en paralelo para resolver problemas. ¿Por qué no suponer que el cerebro se asemeja más a un procesador cuántico? Quizá las respuestas y las propuestas, provengan de mejorar la eficiencia de una computadora cuántica, tan pronto la tengamos en el escritorio de la oficina. ¿Inteligencia artificial cuántica? ¿Esto último si sería física?

Referencias

[1] Prize announcement. NobelPrize.org. Nobel Prize Outreach AB 2024. Thu. 31 Oct 2024. https://www.nobelprize.org/prizes/physics/2024/prize-announcement/

[2] J.J. Hopfield, Neural networks and physical systems with emergent collective computational abilities, Proc. Natl. Acad. Sci. 79 (1984) 2554

[3] G.E. Hinton, Boltzmann machine, Scholarpedia 2 (5): 1668

Foto de portada: Niklas Elmehed. Divulgación del Premio Nobel